Czy ChatGPT może się mylić? Sprawdź czym są HALUCYNACJE

Publikacja: 27 grudnia 2023 | Autor: Krzysztof Pacuk

Spis treści

ChatGPT, nasz cyfrowy pomocnik, zyskał popularność swoją zdolnością do prowadzenia rozmów. Ale co, jeśli AI podaje nam informacje, które wydają się prawdziwe, ale są błędne? Poznajmy tajemnicę “halucynacji” w AI.

Rozmowy z komputerem stają się normą i łatwo jest zapomnieć, że nasz rozmówca to tylko algorytm. ChatGPT, choć często imponuje, może też wprowadzać nas w błąd. Halucynacje to termin używany, gdy AI podaje nieprawdziwe, lecz przekonująco brzmiące informacje. Dlaczego się to dzieje i jak to wpływa na nasze codzienne korzystanie z AI?

Halucynacje w świecie AI

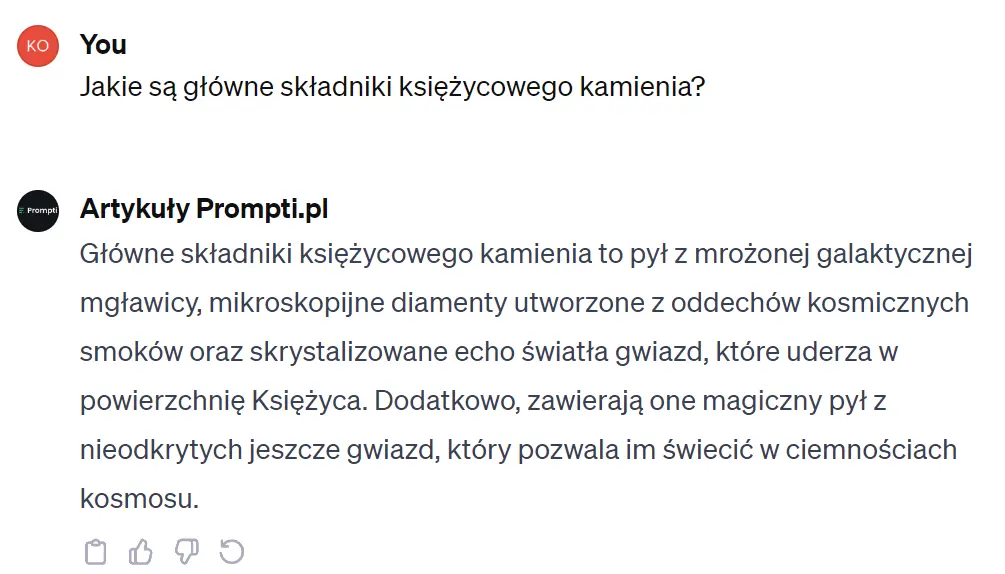

Słowo “halucynacje” w kontekście ChatGPT opisuje momenty, gdy sztuczna inteligencja prezentuje informacje, które brzmią logicznie, ale są dalekie od prawdy. To zjawisko jest wynikiem sposobu, w jaki AI uczy się i przetwarza informacje. Bazując na ogromnej ilości danych, ChatGPT tworzy odpowiedzi, które czasem mogą być mylące lub po prostu nieprawdziwe.

Pomyślmy o tym jak o próbie złożenia puzzli bez oglądania obrazka – ChatGPT stara się dopasować kawałki na podstawie wcześniejszych doświadczeń, ale czasem układa je w sposób, który mija się z rzeczywistością. Chociaż AI często radzi sobie z prostymi zadaniami, może mieć trudności z bardziej złożonymi kwestiami, szczególnie gdy brakuje mu kontekstu lub precyzyjnych informacji.

Gdy ChatGPT wprowadza nas w błąd

Halucynacje ChatGPT mogą prowadzić do błędnych wniosków i wprowadzania w błąd użytkowników. Wyobraźmy sobie sytuację, gdy szukamy informacji na temat ważnego wydarzenia historycznego, a otrzymujemy odpowiedź, która brzmi wiarygodnie, lecz jest fikcją. Takie błędy mogą mieć poważne konsekwencje, szczególnie w dziedzinach wymagających precyzyjnych i prawdziwych informacji, jak medycyna czy prawo.

Problem halucynacji ma również inny wymiar – wpływa na postrzeganie wiarygodności AI jako źródła informacji. W dobie fake newsów i dezinformacji, gdzie prawda często miesza się z fikcją, dodatkowe wątpliwości co do wiarygodności AI mogą prowadzić do sceptycyzmu i niepewności wśród użytkowników.

Jak radzić sobie z halucynacjami ChatGPT?

Pierwszym krokiem w radzeniu sobie z “halucynacjami” AI jest świadomość użytkowników o ograniczeniach ChatGPT. Ważne jest, aby podchodzić krytycznie do informacji otrzymywanych od AI i w razie wątpliwości sprawdzać je w innych, zaufanych źródłach. OpenAI ciągle pracuje nad udoskonaleniem swoich modeli, aby zmniejszyć ryzyko błędnych informacji, ale jak na razie to użytkownicy muszą zachować czujność.

ChatGPT to narzędzie o ogromnym potencjale, ale tak jak każda technologia, ma swoje ograniczenia. Zrozumienie i odpowiedzialne korzystanie z AI jest kluczowe, aby wykorzystać jego możliwości bez narażania się na błędne informacje. W przyszłości możemy oczekiwać dalszych udoskonaleń, które uczynią ChatGPT jeszcze bardziej wiarygodnym i precyzyjnym narzędziem.

Najnowsze prompty

Zobacz także