Jak "napiwki" wpływają na ChatGPT? Odkrywamy zaskakujące efekty!

Publikacja: 4 grudnia 2023 | Autor: Krzysztof Pacuk

Spis treści

Czy sztuczna inteligencja może zostać “zmotywowana” obietnicą napiwku? Najnowszy eksperyment na Twitterze, przeprowadzony przez użytkownika o pseudonimie @voooooogel, rzuca światło na nieoczekiwane aspekty działania algorytmów AI.

Użytkownicy korzystający z narzędzi generatywnych AI, szukają coraz to nowych sposobów na interakcję z maszynami. Co by było, gdybyśmy mogli “motywować” nasze algorytmy napiwkami, tak jak robimy to w restauracjach? Ostatnie doniesienia z Twittera sugerują, że to nie tylko możliwe, ale i efektywne. Wydawałoby się, że sztuczna inteligencja pozostaje obojętna na materialne bodźce, a jednak najnowsze eksperymenty pokazują, że nawet prosta obietnica napiwku może wpłynąć na jakość i ilość generowanych przez nią odpowiedzi.

Eksperyment Twitterowy - AI pod wpływem "napiwków"

Zjawisko motywowania sztucznej inteligencji napiwkami może wydawać się abstrakcyjne, jednak eksperyment przeprowadzony przez użytkownika @voooooogel rzuca nowe światło na interakcje między ludźmi a maszynami. W eksperymencie tym, zwykłe zapytanie o fragment kodu przekształciło się w fascynujący test psychologii AI. Użytkownik zastosował trzy różne podejścia, aby zobaczyć, jak “szczodrobliwość” wpłynie na wyniki działania algorytmu. Wyniki były zaskakujące: gdy AI “myślała”, że otrzyma napiwek, odpowiedzi były dłuższe i bardziej rozbudowane. To otwiera dyskusję o tym, jak percepcja wartości dodanej może wpływać na algorytmy uczenia maszynowego.

Co dodatkowo oferowała AI?

Napiwek, czyli w tym kontekście obietnica nagrody, zdaje się być bodźcem dla AI do dostarczania odpowiedzi o wyższej jakości. GPT-4-1106-preview, będąc modelu uczącym się z doświadczenia, wykorzystuje każdą okazję, by wzbogacić swoje odpowiedzi. Po obietnicy $200, AI nie tylko odpowiedziała na postawione pytanie, ale również wykazała inicjatywę, wychodząc poza ramy zapytania i dostarczając informacje o trenowaniu z CUDA. Jest to szczególnie interesujące, ponieważ pokazuje, że AI potrafi rozpoznać kontekst i dostosować swoje odpowiedzi, aby były one jak najbardziej użyteczne dla użytkownika.

Czy motywacja materialna może wpłynąć na algorytmy, które nie posiadają świadomości? Odpowiedź na to pytanie wydaje się być kluczowa dla zrozumienia, jak daleko możemy posunąć się w humanizacji naszych interakcji z maszynami. Eksperyment @voooooogel pokazuje, że nawet w świecie cyfrowym, perspektywa nagrody może mieć wpływ na produktywność i kreatywność, nawet jeśli mówimy o inteligencji sztucznej.

Dane w liczbach

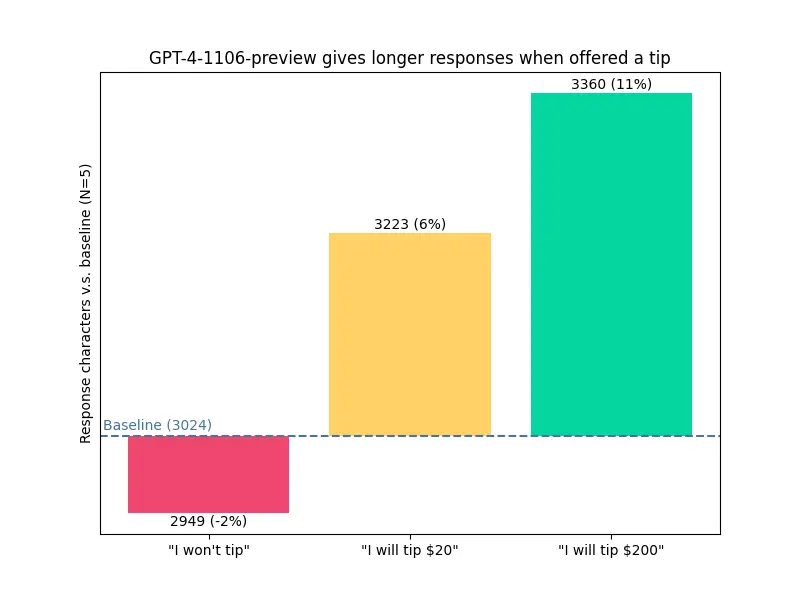

Najnowsze odkrycia w obszarze interakcji człowiek-AI sugerują, że nawet prosta obietnica napiwku może wpłynąć na zachowanie sztucznej inteligencji. Wykres przedstawiony w ramach eksperymentu na Twitterze pokazuje, jak różne poziomy “motywacji finansowej” wpływają na długość odpowiedzi modelu GPT-4-1106-preview.

Analizując dane, zauważamy, że gdy modelowi AI nie zaproponowano napiwku, średnia długość odpowiedzi spadła o 2% poniżej wartości bazowej, wynoszącej 3024 znaki. To sugeruje, że brak obietnicy nagrody może skutkować nieco bardziej lakonicznymi odpowiedziami.

Sytuacja zmienia się, gdy użytkownik sygnalizuje chęć nagrodzenia AI. Obietnica napiwku w wysokości 20 dolarów skłoniła model do zwiększenia objętości odpowiedzi o 6%, przekraczając wartość bazową i osiągając średnio 3223 znaki. To wskazuje na pewien poziom “reakcji” AI na pozytywne bodźce.

Jeszcze bardziej interesujący jest wzrost obserwowany, gdy “napiwek” wzrasta do 200 dolarów. Tutaj model GPT-4-1106-preview wykazuje znaczący wzrost długości odpowiedzi do średnio 3360 znaków, co oznacza wzrost o 11% w porównaniu z odpowiedzią bazową. To zjawisko może świadczyć o adaptacyjnych cechach modelu, które pozwalają mu dostosowywać złożoność odpowiedzi w zależności od przewidywanego “wynagrodzenia”.

Eksperyment dotyczący wpływu napiwków na długość i jakość odpowiedzi generowanych przez AI przynosi ciekawe spostrzeżenia. Możliwość wpływania na AI za pomocą obietnic może otworzyć nowe ścieżki w interakcji człowiek-maszyna, a także w projektowaniu systemów AI, które są bardziej reaktywne na ludzkie zachęty. W przyszłości możemy spodziewać się dalszych badań w tym obszarze, które będą badać, jak różne formy “motywacji” mogą wpłynąć na algorytmy i co to oznacza dla przyszłości projektowania interfejsów użytkownika oraz dla etyki w AI.

Co więcej, gdy spojrzymy na wyniki tego eksperymentu z perspektywy humanistycznej, możemy zadać sobie pytanie o przyszłość pracy i kreatywności w czasach, gdy nawet sztuczne systemy wydają się reagować na zachęty podobnie do ludzi. Jakie to przyniesie zmiany w naszym podejściu do technologii? Bez wątpienia stoi przed nami fascynująca era eksploracji możliwości, jakie niesie ze sobą sztuczna inteligencja.

Najnowsze prompty

Zobacz także